Proteção de dados e IA: como usar inteligência artificial com segurança e conformidade à LGPD

Crescer com IA sem correr riscos ou cair em manchetes negativas por conta de proteção de dados é o grande desafio das empresas hoje. Quando pensamos em uso de inteligência artificial e prompts de IA, precisamos também olhar para segurança de dados e da informação.

A inteligência artificial já faz parte da rotina das empresas, mas ainda existem muitos medos e dúvidas sobre segurança e conformidade com a LGPD.

A falta de informação sobre segurança e proteção de dados não pode ser um obstáculo para a transformação digital. É possível usar IA e agentes inteligentes de forma ética, em conformidade com a LGPD e com segurança digital.

Segundo a Gartner, 48% das organizações com alta maturidade em IA apontam a segurança da informação como o principal desafio. Mesmo assim, é possível acelerar o uso da inteligência artificial sem violar a privacidade.

Neste artigo, você vai entender como unir LGPD e IA para transformar risco em diferencial competitivo.

Veja neste artigo:

- Por que segurança e proteção de dados são prioridade no uso de IA

- Os principais riscos de proteção de dados e IA

- Erros comuns em proteção de dados e IA

- Checklist de como aplicar a LGPD em projetos de IA

- Anonimização e pseudonimização: técnicas essenciais para segurança

- Treinamento de modelos e retenção de dados: os riscos invisíveis

- Como a governança transforma risco em diferencial competitivo

- O marco legal da inteligência artificial no Brasil

- Como o Zeev ajuda a aplicar proteção de dados e IA na prática

Por que segurança e proteção de dados são prioridade no uso de IA

Empresas que avançam em IA se deparam com o mesmo desafio: como crescer sem expor dados sensíveis. Em 2024, 77% das organizações bloquearam o uso de ferramentas de IA generativa por medo de vazamentos.

Segundo Rafael Bortolini, diretor de IA e automação na Stoque, essa medida é apenas um reflexo da falta de governança:

“Bloquear o uso de IA não resolve o problema. O caminho é estruturar políticas, classificar informações e orientar as equipes sobre o que pode ou não ser compartilhado.”

A base da segurança está na governança de dados, que define papéis, responsabilidades e controles técnicos dentro da empresa.

| Desafio | Solução prática |

| Uso indevido de dados em ferramentas abertas | Criar políticas internas e registrar atividades |

| Falta de transparência sobre armazenamento | Elaborar o Relatório de Impacto à Proteção de Dados (RIPD) |

| Risco de vazamentos e reidentificação | Aplicar anonimização e pseudonimização antes do envio de dados |

Os principais riscos de proteção de dados e IA

Com o avanço da IA generativa, cresce um novo fenômeno: o Shadow AI. O termo define o uso de ferramentas de IA por colaboradores sem autorização da área de TI.

Segundo pesquisa da IBM, 38% dos funcionários admitem usar IA sem permissão da empresa. Essa prática expõe dados confidenciais, pessoais e estratégicos sem controle.

Eugênio Corassa, advogado de proteção de dados e direito digital, reforça a importância de diferenciar as informações tratadas no dia a dia:

“As empresas precisam classificar o que é público, interno, confidencial ou secreto. Sem essa cultura, o colaborador não sabe o que pode compartilhar e expõe a organização a riscos sérios.”

| Tipo de dado | Exemplos | Risco principal |

| Pessoal | Nome, CPF, e-mail, IP | Reidentificação e vazamentos |

| Sensível | Saúde, religião, biometria | Violação de direitos e sanções legais |

| Corporativo | Contratos, planilhas, relatórios internos | Perda de propriedade intelectual |

Erros comuns em proteção de dados e IA

Mesmo com boas intenções, muitas empresas ainda cometem erros básicos que comprometem a segurança dos dados.

- Enviar informações confidenciais para ferramentas públicas de IA.

- Falta de integração entre TI, Jurídico e Processos.

- Usar provedores sem cláusulas claras de privacidade.

- Não definir papéis e responsabilidades (como DPO).

Essas falhas abrem brechas para incidentes e podem gerar multas de até 2% do faturamento, segundo a ANPD.

Checklist de como aplicar a LGPD em projetos de IA

Proteger dados em IA é uma ação que começa na estratégia, não na reação. Implementar a LGPD dentro dos fluxos de IA garante transparência, rastreabilidade e segurança.

As principais ações são:

- Classificar os dados da empresa (públicos, internos, confidenciais e secretos).

- Criar o Relatório de Impacto à Proteção de Dados – RIPD antes da implantação de IA.

- Definir políticas de retenção e descarte de dados usados em modelos.

- Escolher provedores com opção de opt-out de treinamento de modelos.

- Treinar equipes sobre privacidade, compliance e uso ético de IA.

Essas práticas reduzem riscos e demonstram responsabilidade jurídica e técnica.

Anonimização e pseudonimização: técnicas essenciais para segurança

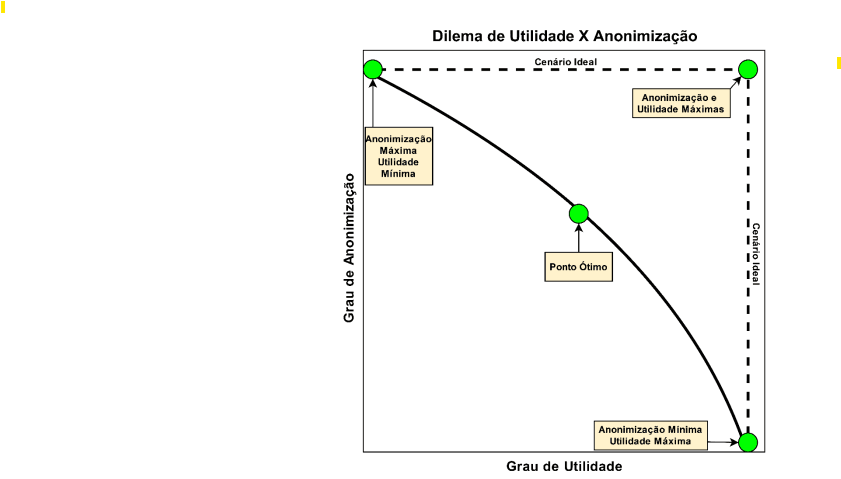

Segundo a o estudo técnico da ANPD, a anonimização de dados é um processo técnico que reduz ou elimina a possibilidade de identificar uma pessoa a partir de um conjunto de dados (p. 4–6). Esse processo deve ser contínuo e baseado em risco, considerando o equilíbrio entre utilidade do dado e grau de anonimização (p. 5–7).

A pseudonimização, por outro lado, substitui informações pessoais por chaves, códigos ou identificadores artificiais, mantendo a possibilidade de reversão quando necessário (Apêndice I, p. 20–23).

Diferença entre anonimização e pseudonimização

Enquanto a anonimização visa retirar completamente o vínculo com o titular, a pseudonimização permite rastrear os dados em contextos de auditoria, controle interno e compliance.

As duas técnicas podem ser aplicadas em conjunto, de acordo com a finalidade do tratamento e o nível de risco aceitável definido pelo controlador (p. 8–10).

| Critério | Anonimização | Pseudonimização |

| Objetivo | Eliminar qualquer possibilidade razoável de identificação do titular (p. 4–6). | Substituir dados pessoais por identificadores artificiais, mantendo a possibilidade de reversão (p. 20–23). |

| Base legal (LGPD) | Art. 12, §3º da LGPD – dados anonimizados deixam de ser considerados pessoais. | Art. 13 da LGPD – técnica de segurança e mitigação de risco dentro do tratamento. |

| Quando aplicar | Em projetos de IA, BI ou pesquisa que não precisam identificar indivíduos. | Em processos internos que exigem rastreabilidade, como auditorias e investigações. |

| Benefício principal | Reduz risco de reidentificação e protege totalmente o titular. | Mantém integridade e permite rastrear informações quando necessário. |

| Limitações | Pode comprometer a utilidade se aplicada de forma excessiva (p. 7–8). | Mantém risco residual de reidentificação se não houver controle das chaves (p. 9–10). |

| Nível de risco residual | Muito baixo, se as técnicas forem bem aplicadas. | Médio, pois depende da gestão das chaves e do contexto. |

| Exemplo de uso corporativo | Treinamento de modelos de IA com bases anonimizadas. | Gestão de cadastros internos e logs de sistemas. |

O dilema entre utilidade e anonimização

A ANPD explica que a anonimização deve ser tratada como um processo contínuo e baseado em risco. Pensando nisso, é importante que cada empresa precisa encontrar o ponto de equilíbrio entre utilidade do dado e nível de anonimização. Quanto mais os dados são protegidos, menor tende a ser sua utilidade prática para análises e projetos de IA (p. 5–7).

A figura mostra que existe um ponto ótimo em que a utilidade e a anonimização atingem equilíbrio. Esse ponto varia conforme o contexto, o tipo de dado tratado e a finalidade do processamento. A abordagem baseada em risco ajuda o controlador a ajustar esse equilíbrio, evitando tanto o excesso de exposição quanto a perda de valor dos dados.

Fonte: ANPD (2023). Estudo Técnico sobre Anonimização de Dados na LGPD. Brasília, p. 6.

Treinamento de modelos e retenção de dados: os riscos invisíveis

Um dos temas mais críticos de proteção de dados e IA está no treinamento e na retenção de informações.

Segundo Rafael Bortolini,

“Os modelos de IA são alimentados por informações disponíveis no mundo. O risco começa quando dados privados da empresa entram nesse ecossistema sem controle.”

Quando dados são usados em modelos abertos, partes dessas informações podem ser armazenadas e até reaparecer em respostas futuras.

Além disso, muitos provedores mantêm o histórico de conversas por tempo indeterminado, o que amplia o risco de vazamento.

O ideal é avaliar as políticas de privacidade de cada provedor e desativar o compartilhamento para treinamento (opt-out) sempre que possível.

Como a governança transforma risco em diferencial competitivo

Empresas que tratam proteção de dados e IA como parte da estratégia ganham vantagem competitiva. A governança de IA garante previsibilidade, eficiência e reputação positiva.

| Benefício | Impacto prático |

| Previsibilidade | Processos rastreáveis e decisões seguras |

| Eficiência | Dados confiáveis e automações seguras |

| Confiança | Imagem sólida e transparente diante do mercado |

Leia também: O que são agentes de IA e como eles funcionam dentro do Zeev

O marco legal da inteligência artificial no Brasil

O PL 2338/2023, em tramitação no Senado, propõe o marco legal da IA no Brasil.

O projeto cria regras de transparência, segurança e responsabilização para uso de inteligência artificial.

Empresas que se antecipam a essas diretrizes ganham agilidade e reduzem riscos futuros.

Como o Zeev ajuda a aplicar proteção de dados e IA na prática

O Zeev é uma plataforma low-code que permite criar fluxos e agentes de IA em conformidade com a LGPD. Você estrutura processos, define regras de uso e mantém controle total sobre dados e acessos em um só lugar.

O sistema garante rastreabilidade, auditoria e versionamento de documentos, o que traz segurança e transparência para todos os times envolvidos.

Com o BPMS da Zeev, o uso da inteligência artificial acontece dentro de fluxos seguros, auditáveis e governados. Para complementar, o workflow Zeev já possui IA nativa, a Zai IA que analisa dados, identifica riscos e sugere melhorias automáticas dentro dos processos, além de criar fluxos.

Na prática, isso significa ter uma IA que entende os fluxos corporativos e atua para torná-los mais eficientes, seguros e transparentes.

O Zeev também é uma plataforma premiada internacionalmente, reconhecida com o Global Excellence in BPM & Workflow Award, uma das maiores premiações mundiais em gestão de processos, pela inovação e impacto em automação corporativa.

Fale com um especialista Zeev e veja como aplicar proteção de dados e IA nos seus fluxos de TI, Jurídico e Processos com segurança, previsibilidade e inteligência.